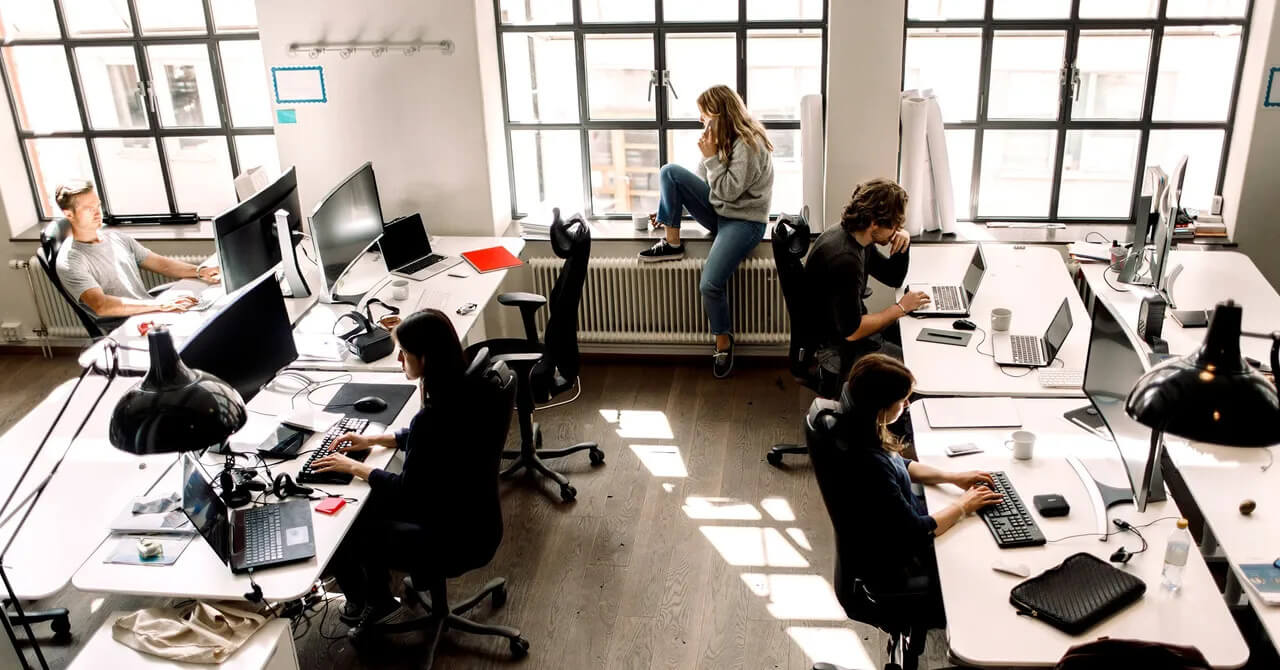

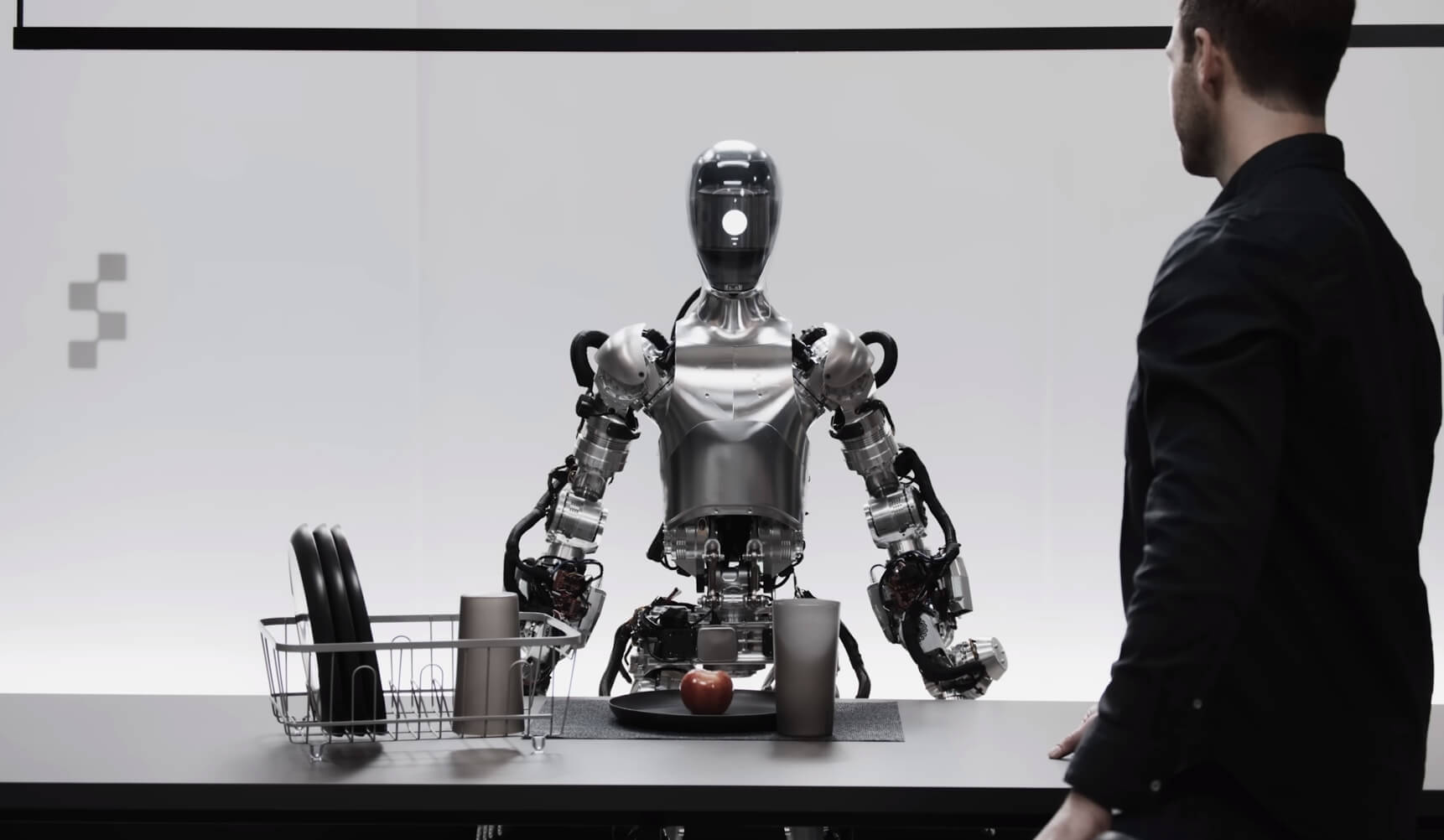

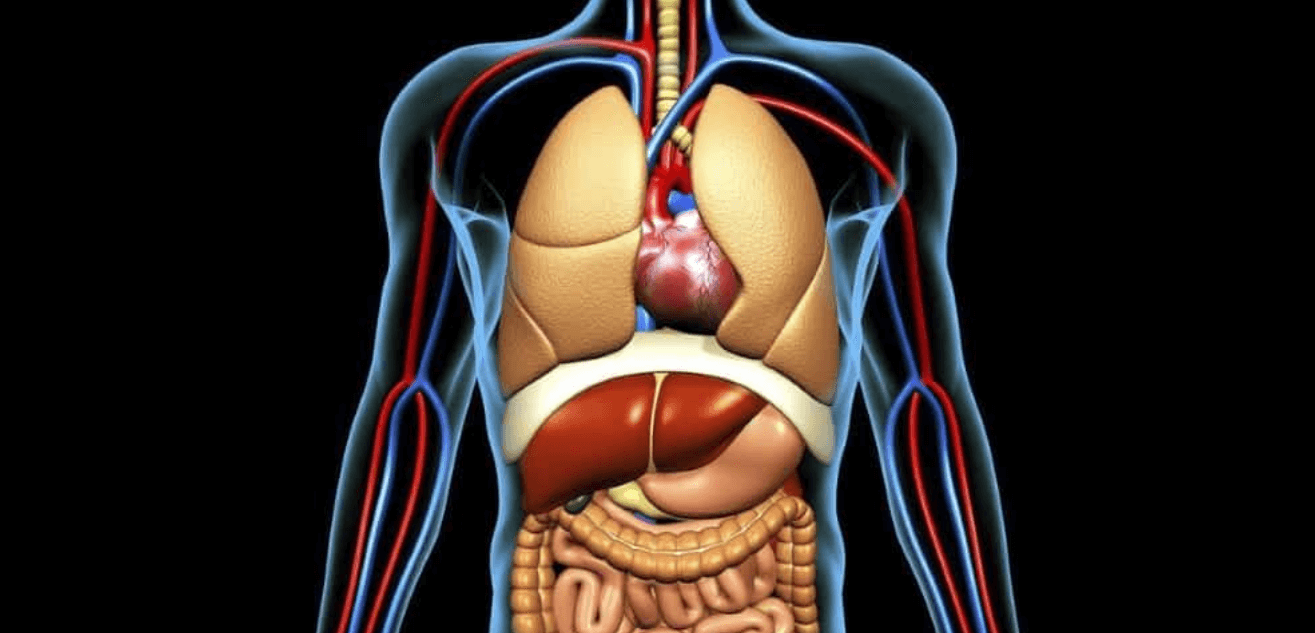

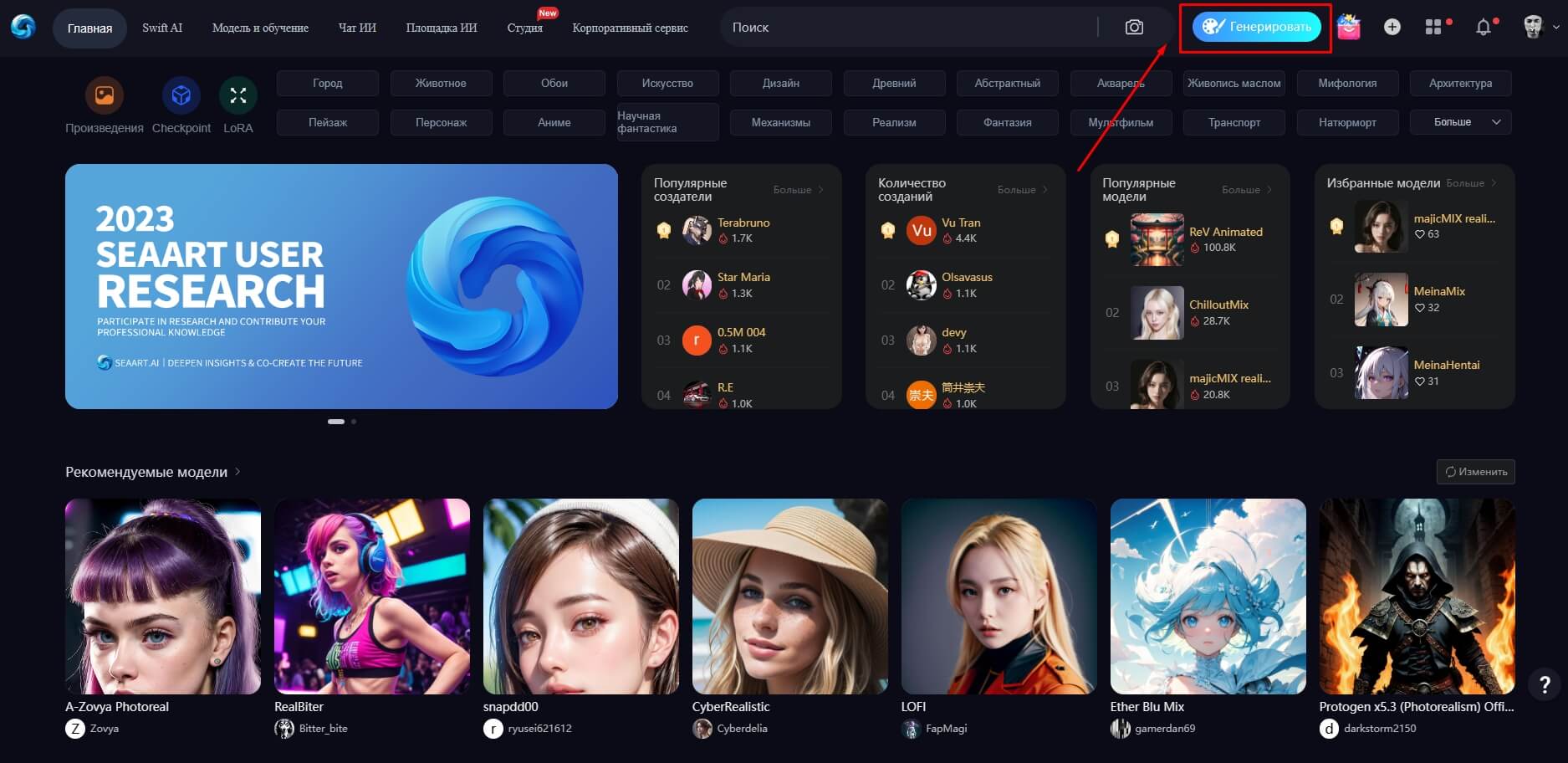

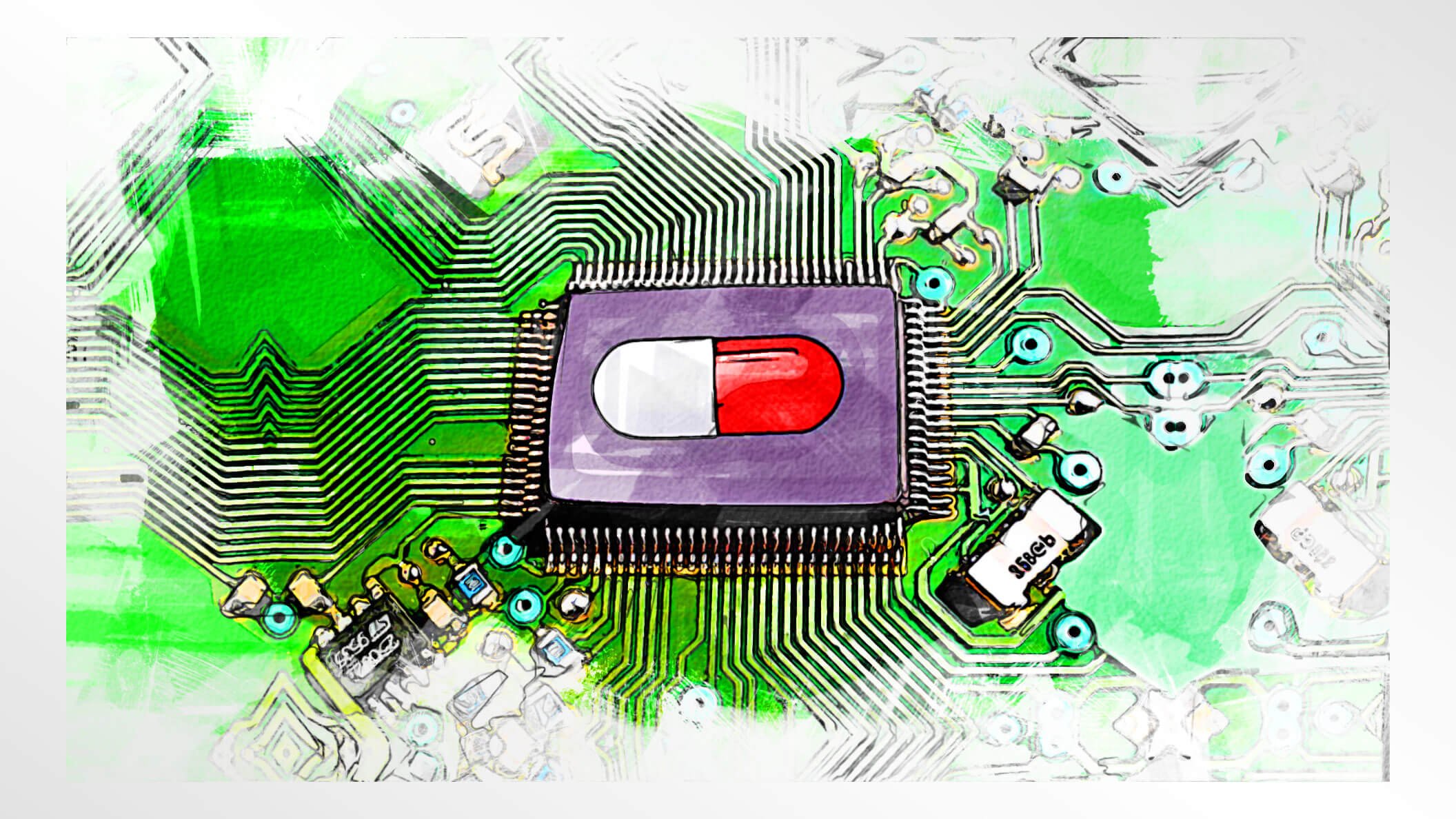

Разработчики лекарств стремятся ускорить тестирование и разработку новых лекарств с помощью искусственного интеллекта (ИИ). Изображение: Economist.com

На протяжении десятилетий исследователи стремились ускорить разработку лекарств. Однако этот процесс становился все медленнее, рискованнее и требовал больших финансовых вложений. Так, от начала программы разработки до момента выдачи разрешения на продажу уходит от 12 до 15 лет, а девять из десяти препаратов, которые проходят клинические испытания, и вовсе не получают одобрения. Стоит ли говорить о стоимости вывода лекарственных средств на рынок – согласно оценкам, эта процедура обходится в миллиарды долларов. Фармацевтические компании, однако, изо всех сил стараются внедрять инновации, включая современные системы искусственного интеллекта (ИИ), который радикально сокращает этапы, предшествующие клиническим испытаниям. На данный момент исследователи из университетов и ведущих фармацевтических компаний проверяют, может ли ИИ значительно сократить продолжительность этапа открытия и разработки новых медицинских препаратов. Неужели нас ожидает скорое появление самых разнообразных лекарств? Давайте разбираться!

Искусственный интеллект может помочь ускорить разработку лекарств, но только в том случае, если мы предоставим ему правильные данные

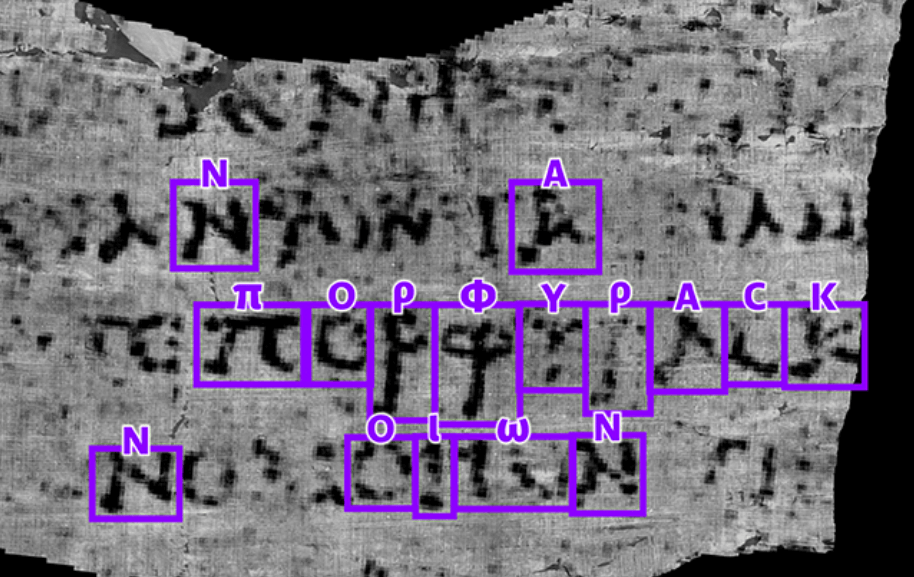

Нейросети, лекарства и яды

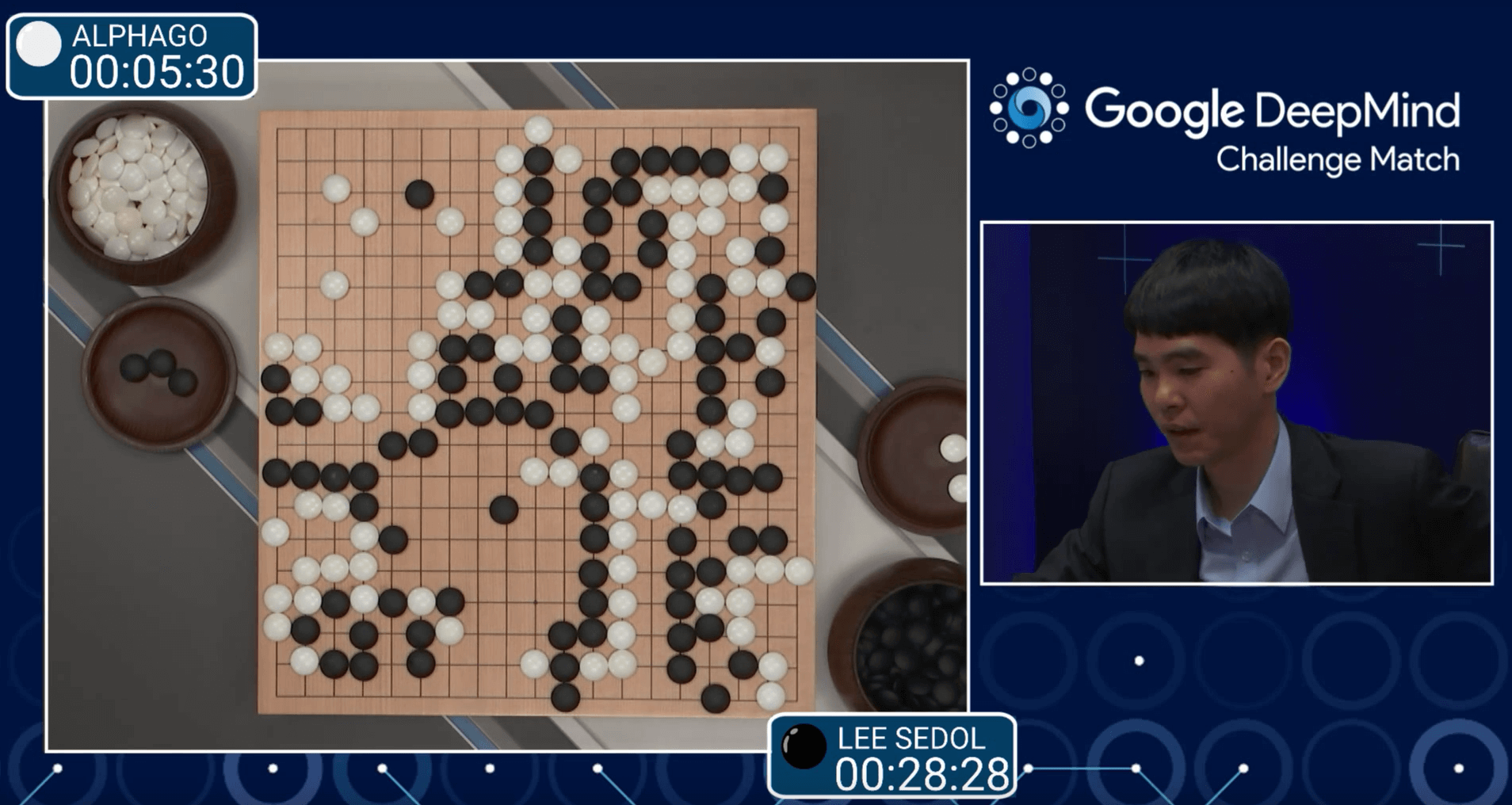

Год назад мы рассказывали об исследовании, результаты которого полностью так и не были опубликованы – все из-за повышенной секретности и рисков, которые несет в себе разработка медицинских препаратов с помощью генеративного ИИ. Тогда авторы работы, опубликованной в журнале Nature Machine Intelligence обнаружили, что ИИ может в кратчайшие сроки создавать как новые лекарства, так и биологическое оружие.

Да-да, вы не ослышались – представленная система искусственного интеллекта MegaSyn, обученная соединять молекулы в комбинации, всего за шесть часов создала более 40 000 потенциально опасных молекулярных соединений, многие из которых оказались более токсичными, чем все существующие вещества нервно-паралитического действия. К счастью, ни одного из сгенерированных системой соединений в реальности не существует, однако риски огромны, а значит к вопросу нужно подходить с умом.

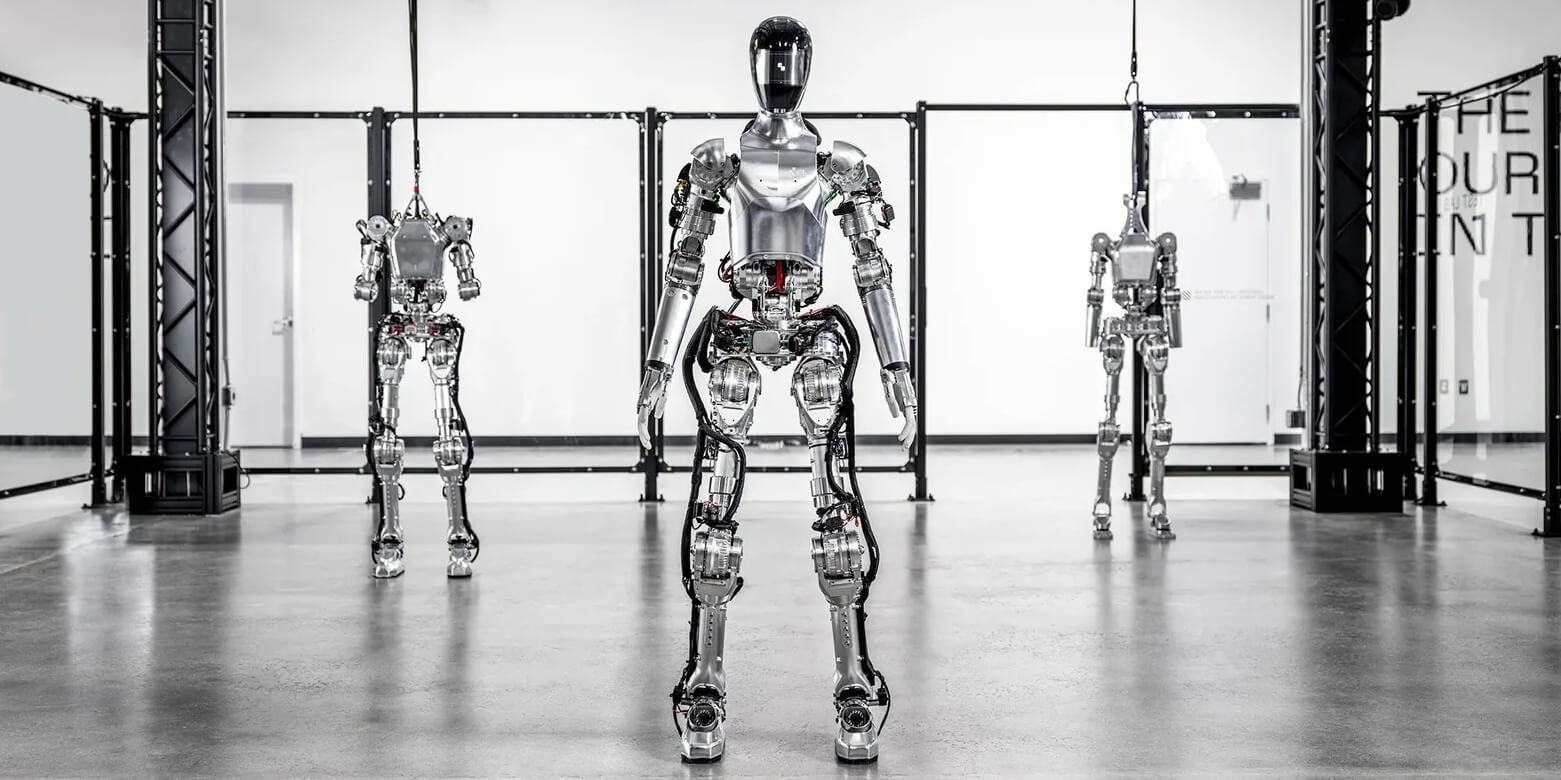

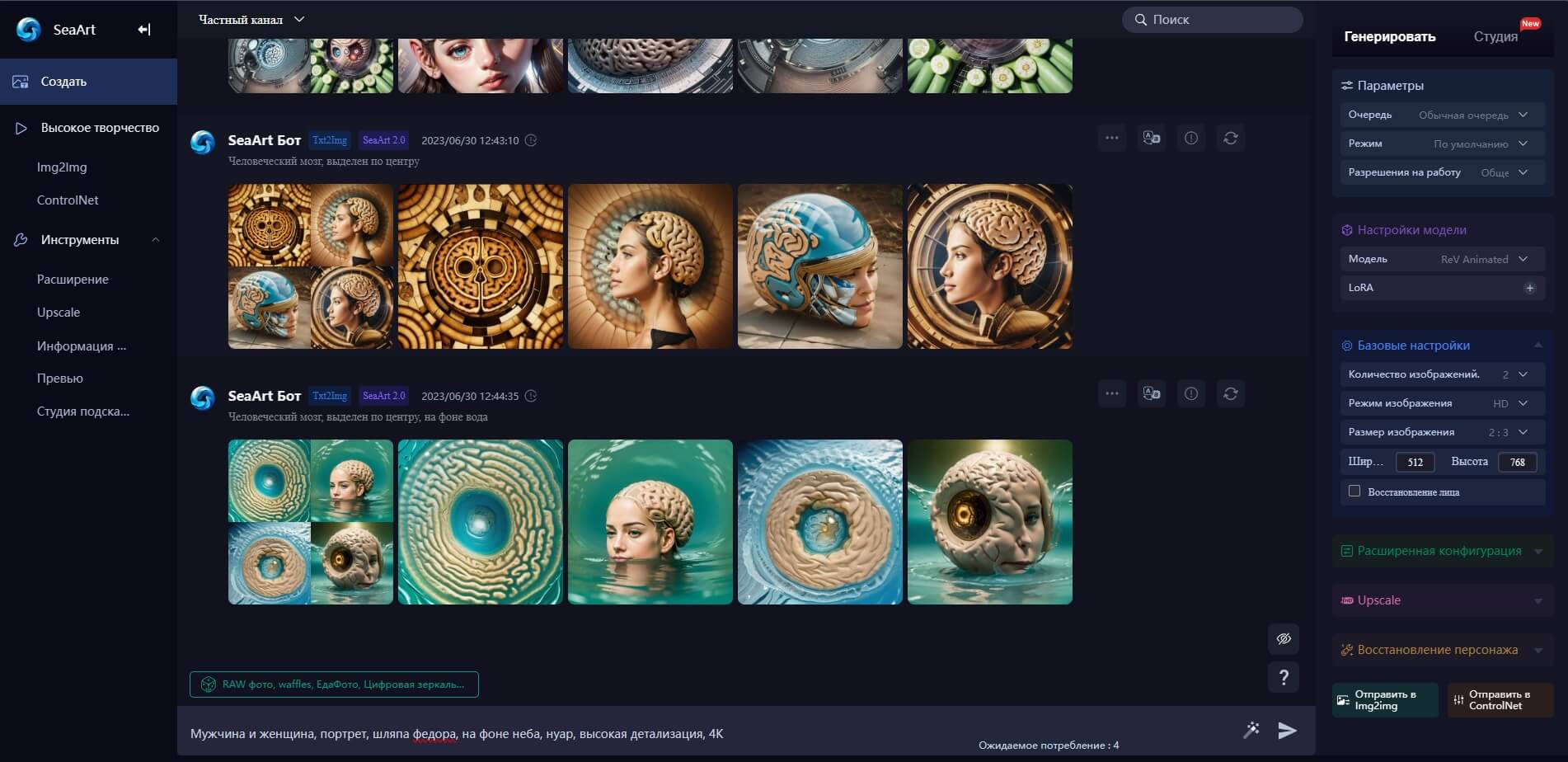

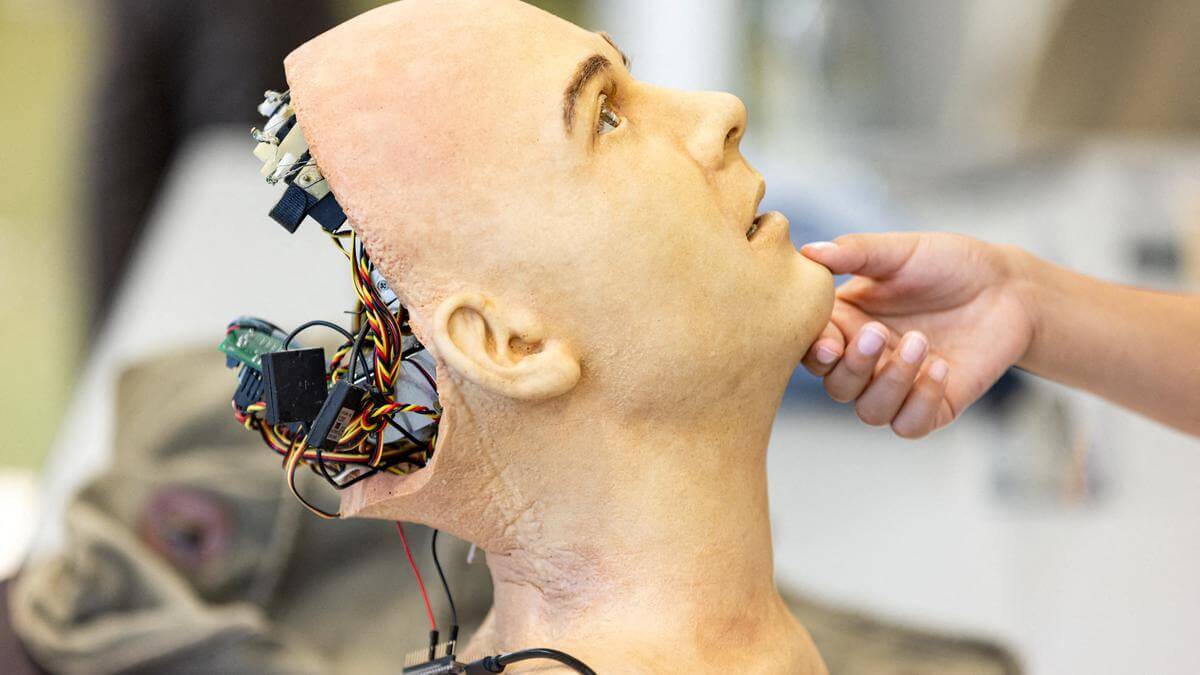

Искусственный интеллект меняет подход и методы создания и разработки новых лекарств. Изображение: fastcompany.com

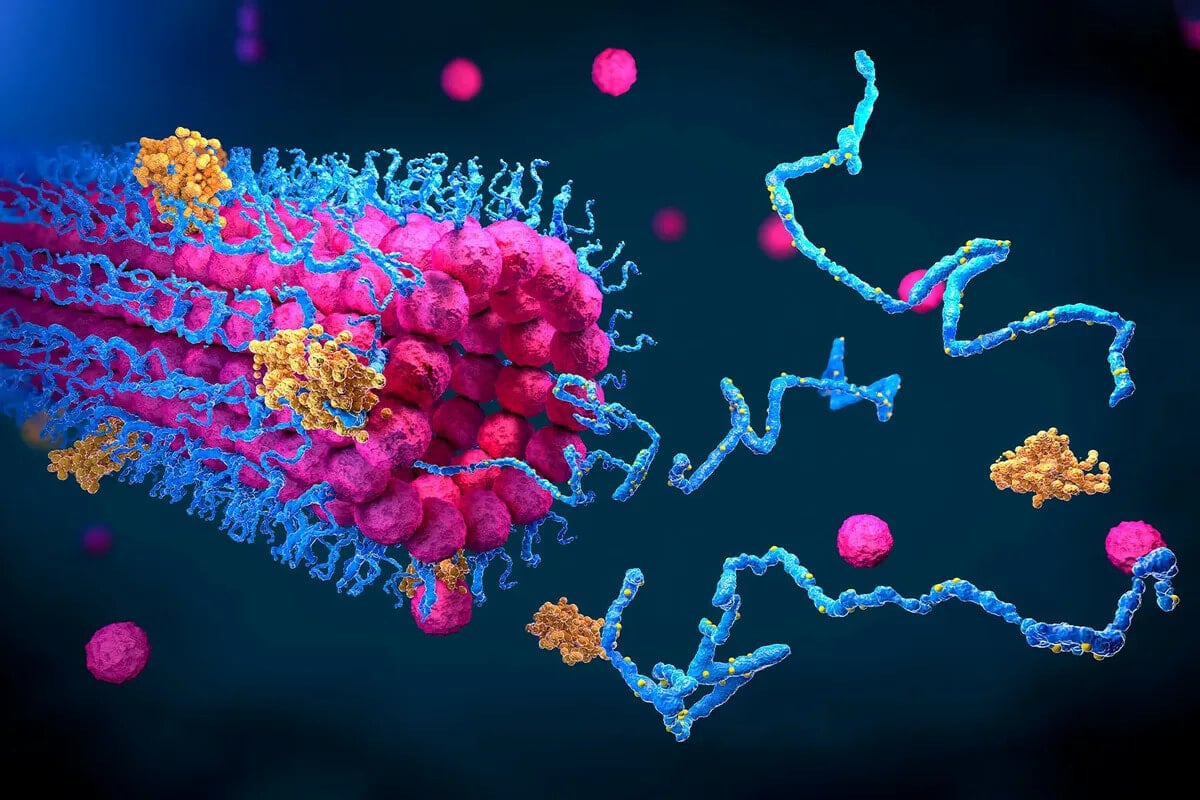

Так как искусственный интеллект может анализировать огромные массивы данных за считанные дни, исследуя сложные белковые структуры и оценивая потенциальные молекулы-мишени, потенциал для открытия новых лекарств огромен. И по мере развития машинного обучения этот процесс будет ускоряться.

Еще больше интересных статей о последних научных открытиях в области медицины и биотехнологий читайте на нашем канале в Яндекс.Дзен – там регулярно выходят статьи, которых нет на сайте!

По мнению большинства исследователей, современный генеративный ИИ едва ли ускорит процесс клинических испытаний лекарств, но потенциально может помочь сократить длительный период, в течение которого определяется «биологическая мишень, ответственная за заболевание» и «скрининг молекул, способных с ней взаимодействовать».

Кто использует ИИ для разработки лекарств?

Сегодня крупные фармацевтические компании инвестируют в развитие ИИ-систем для разработки лекарств. То же самое делают как крупные технологические фирмы, включая Google, так и многие стартапы. Так, по данным Financial Times, компания Isomorphic Labs, занимающаяся разработкой лекарств с использованием ИИ, уже подписала миллиардные контракты с фармацевтическими компаниями, обещая «революцию длительного процесса разработки» и «сокращения времени, затрачиваемого на поиск новых препаратов».

Стартапы, ориентированные на искусственный интеллект, уже появились в США (Recursion и Genesis Therapeutics), Гонконге (Insilico) и Великобритании (Relay Therapeutics). Более того, по мнению руководителя Insitro Дафны Коллер, большим языковым моделям больше не нужно что-то объяснять и обучать их. Доказательством этому служит компания Nvidia, которая за прошедший год инвестировала или заключила партнерские соглашения по меньшей мере с шестью различными биотехнологическими фирмами, специализирующимися на искусственном интеллекте.

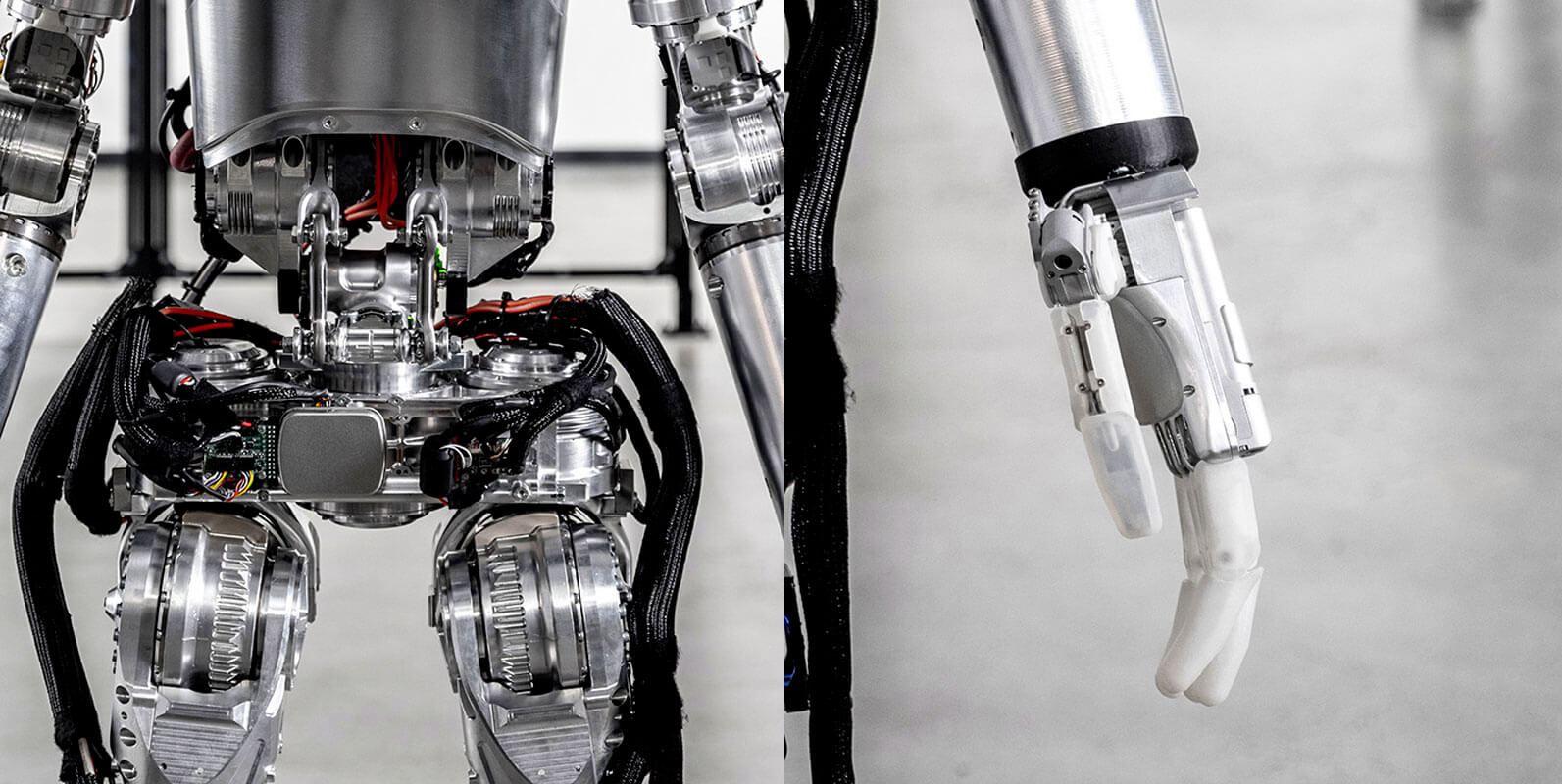

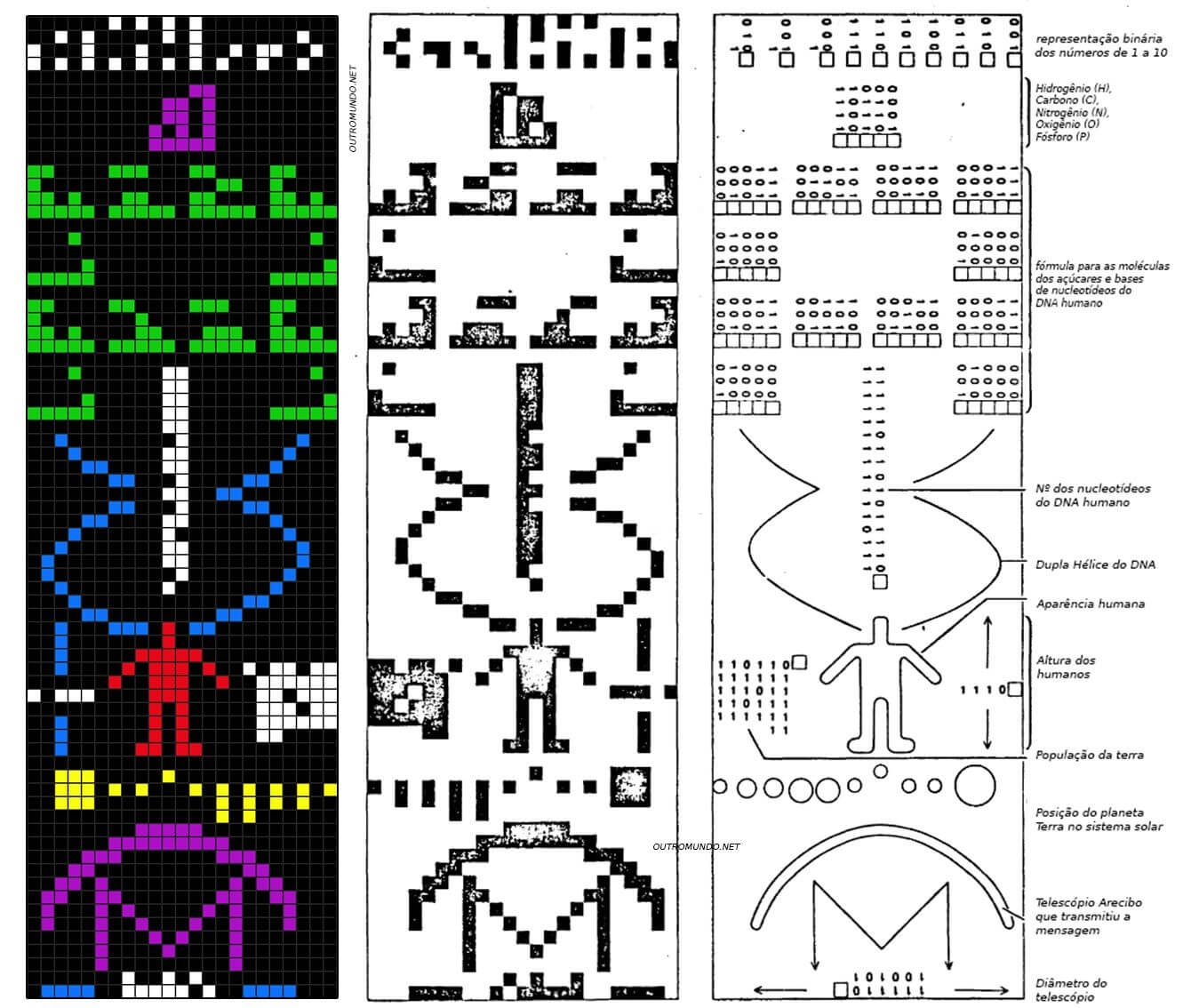

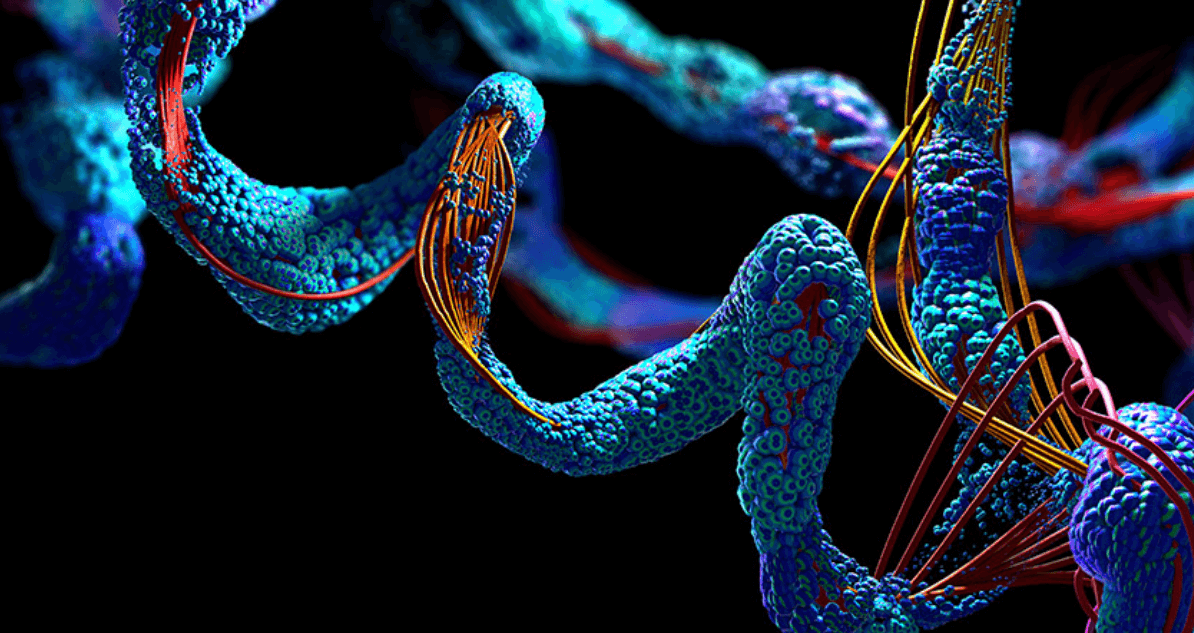

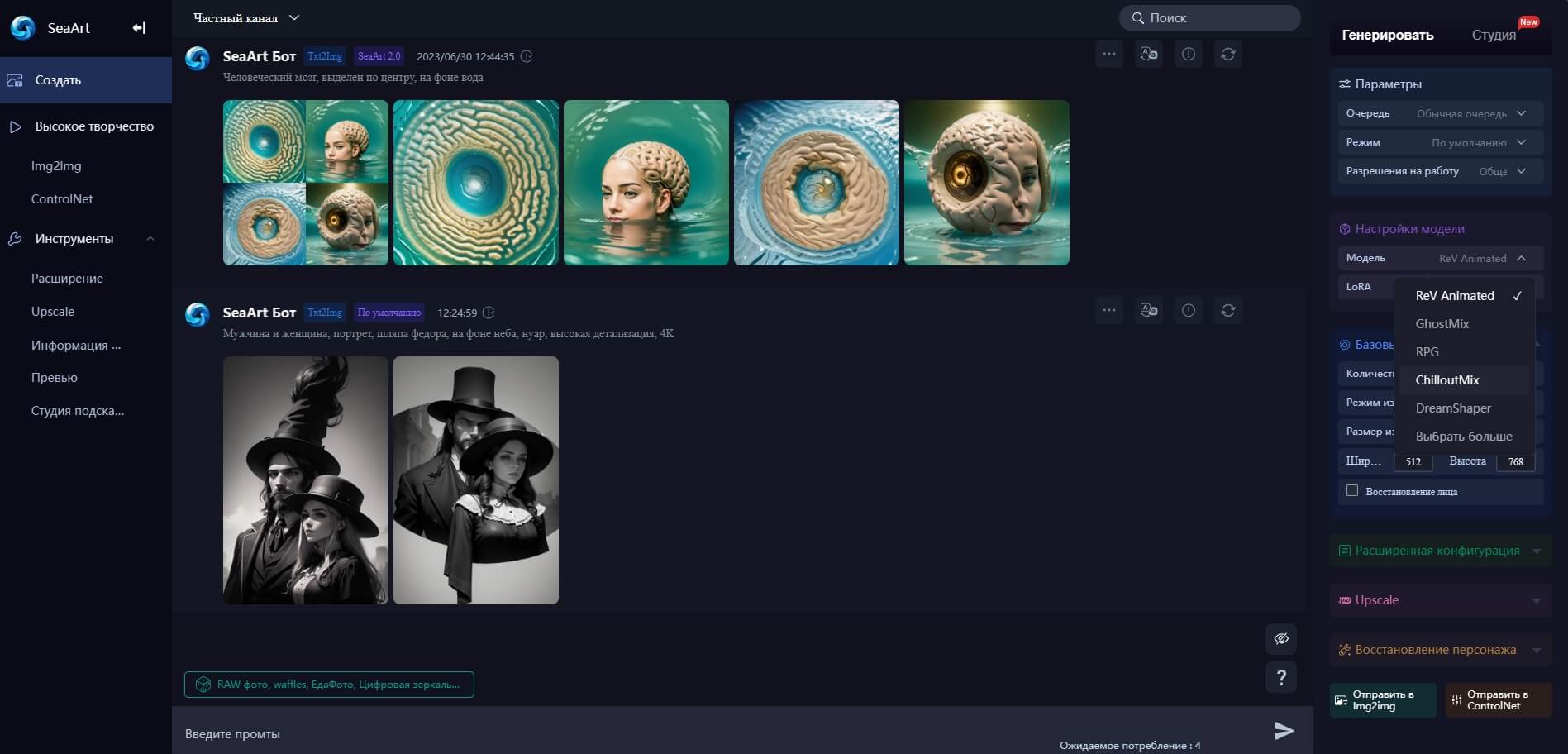

ИИ-системы генерируют огромное количество молекулярных и белковых соединений. Изображение: pharma-mkting.com

Это интересно: Нейросети сделают лекарства более дешевыми и доступными

Интересно, что модели разработки лекарств, которые используют многие компании, включают широкий спектр биологических данных, таких как последовательность генома, изображение клеток и тканей, структур соответствующих белков, биомаркеров в крови, белков, вырабатываемых в конкретных клетках, а также клинических данных о течении заболевания и влиянии лекарственных препаратов и методы лечения пациентов. После обучения такие системы можно точно настроить и расширить их возможности.

Особый интерес представляет использование данных о пациентах. По вполне очевидным причинам часто невозможно точно определить механизм развития заболевания у людей, поэтому при разработке лекарств, как правило, во многом используются модели на животных, хотя они могут вводить в заблуждение.

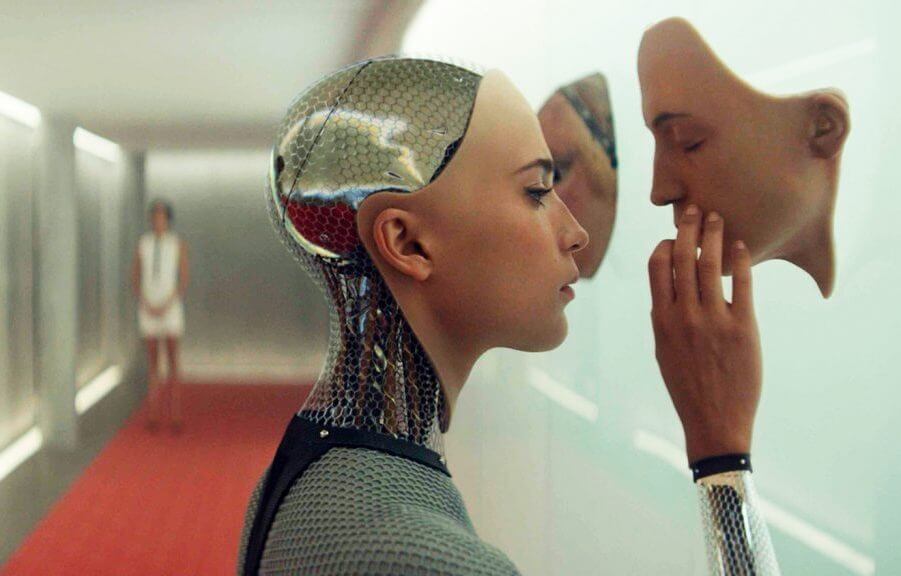

ИИ-системы обладают огромным потенциалом. Изображение: statnews.com

Так, ИИ, обученные биологии человека и лучше приспособленные к ней, могут помочь избежать некоторых тупиковых ситуаций, препятствующих разработке лекарств, – отмечают специалисты.

Например, компания Insitro обучает свои модели работе с патологоанатомическими данными, последовательностью генома, данными МРТ и биохимическими анализами крови. Одна из моделей компании способна связать изменения во внешнем виде клетки под микроскопом с мутациями, лежащими в основе генома, а также с клиническими исходами при различных заболеваниях. Представители компании надеются использовать эти и аналогичные методы для выявления подгрупп онкологических больных, которые будут особенно успешны при прохождении определенных курсов лечения. Согласитесь, звучит неплохо.

Читайте также: Что такое электрохимиотерапия и насколько она эффективна?

Разработка и клинические испытания

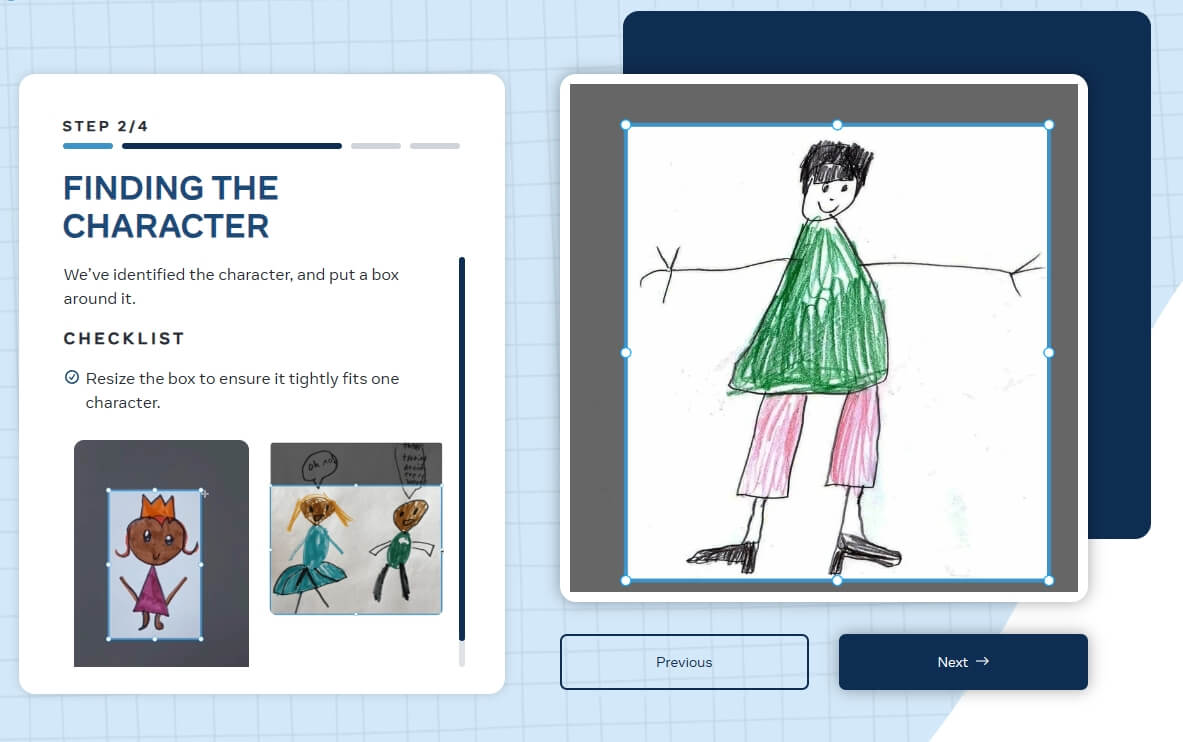

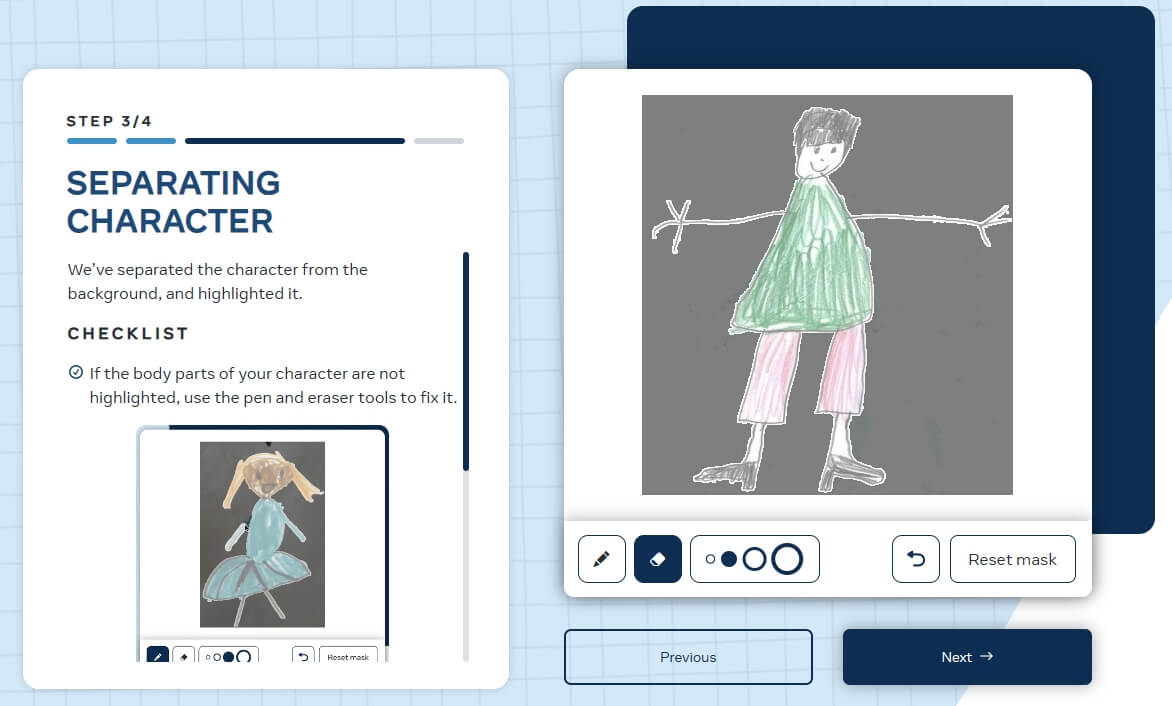

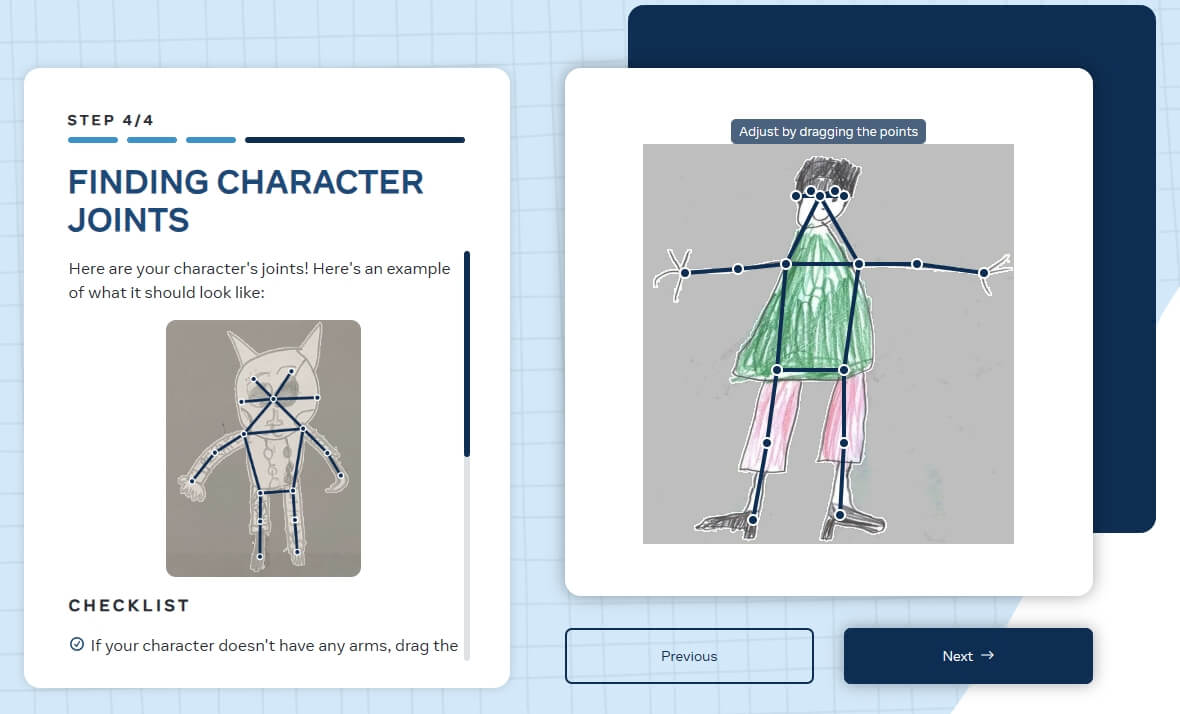

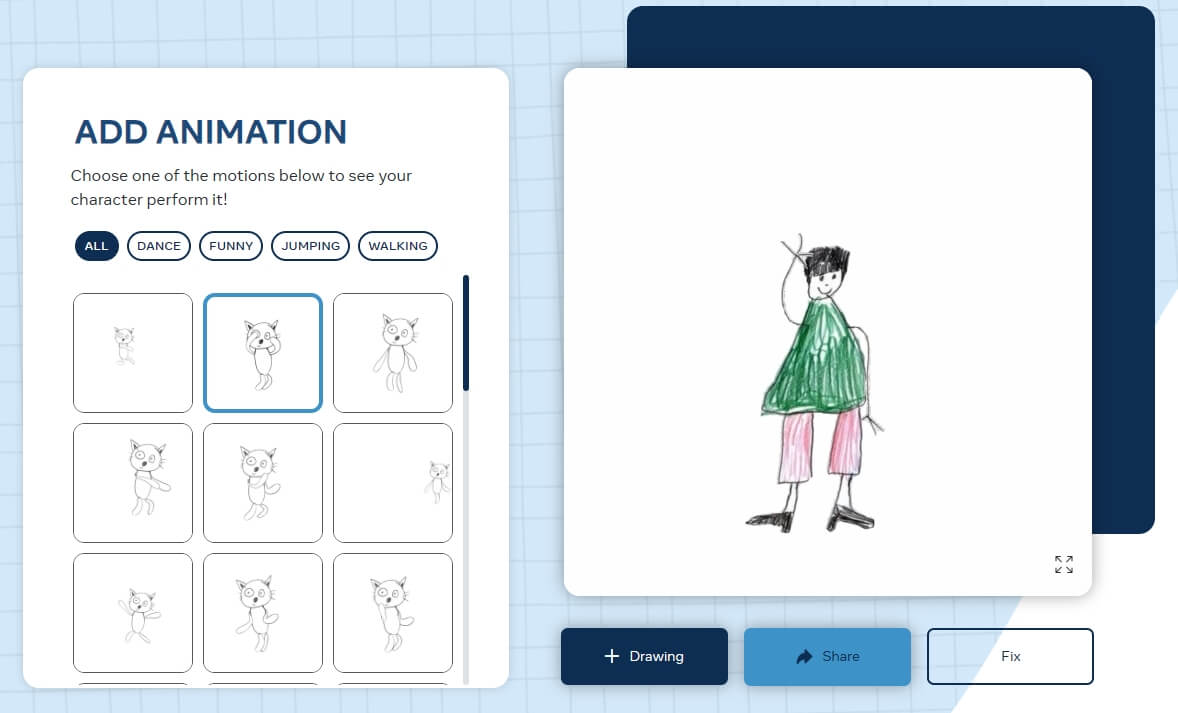

Отметим, что разработка лекарств включает в себя ряд конкретных этапов. Часто все начинается с определения биологической мишени, ответственной за заболевание – это ДНК, РНК, белковый рецептор или фермент — а затем проводится скрининг молекул, которые могут взаимодействовать с ней. Этот этап называется «открытие».

В результате для большинства лекарств получаются молекулы небольшого размера, после чего ученые работают над улучшением их активности и устранением любых связанных с этим проблем. Если им это удается, начинается разработка молекулы—образца для следующего этапа – доклинических испытаний, включающих тесты, с помощью которых ученые понимают как потенциальный препарат транспортируется, расщепляется и выводится организмом.

Процесс разработки и изготовления лекарств занимает минимум 6 лет. Изображение: fastcompany.com

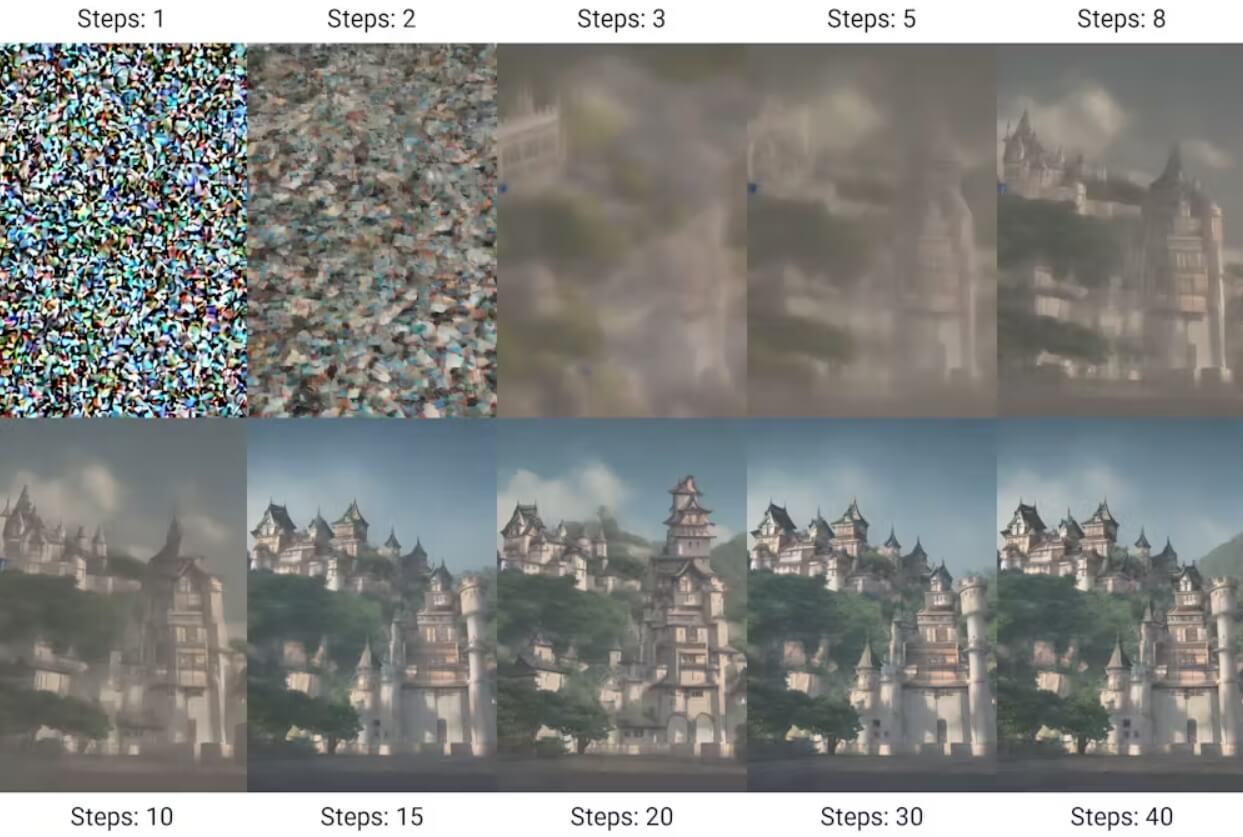

В ходе второго этапа также проводится проверка безопасности и дозировки. Если все проходит успешно, препарат получает одобрение для проведения клинических испытаний. Все этапы открытия и доклинических испытаний занимают в среднем шесть лет. Так, в отчете, опубликованном компании BCG и исследовательским фондом Wellcome, говорится, что искусственный интеллект может обеспечить «экономию времени и средств как минимум на 25-50%» при разработке лекарств вплоть до доклинической стадии.

Вам будет интересно: Голые землекопы долго живут и почти не болеют — шаг к созданию лекарства от старения уже сделан

Как ИИ ускорил процесс разработки лекарств?

Фармацевтическая компания Insilico Medicine, штаб-квартиры которой расположены в Нью-Йорке и Гонконге, объявила что перешла к первой фазе клинических испытаний препарата, разработанного с помощью искусственного интеллекта. Молекула нацелена на идиопатический легочный фиброз – серьезное заболевание, которое приводит к образованию неизлечимых рубцов в легких.

Разработка нового препарата и его доклинические испытания завершились всего за 30 месяцев. В июне прошлого года компания приступила ко второму этапу испытаний, в ходе которого специалисты подробно изучают эффективность нового лекарства. Более того, сегодня уже около 20 компаний активно используют ИИ и перешли к доклиническим испытаниям, а в разработке находятся 158 препаратов.

ИИ-системы прекрасно работают но могут ошибаться. Изображение: mediaproxy.salon.com

Эти утверждения, однако, исходят от самих компаний и до тех пор, пока они не будут подтверждены независимыми экспертами, необходимо соблюдать осторожность. В конечном итоге все полученные в ходе испытаний и разработки результаты должны быть опубликованы в рецензируемых научных журналах, не связанными с соответствующими компаниями.

Не пропустите: Самые жуткие «лекарства» в истории человечества

Не стоит также забывать и о других проблемах, связанных с ИИ-системами – известно, что многие модели считают ряд молекул-кандидатов в лекарственные препараты эффективными, основываясь на шаблонных данных, загруженных для обучения. А мы с вами это уже проходили и знаем, что тот же чат-бот ChatGPT иногда выдумывает ответы. Это означает, что некоторые ИИ-системы могут попросту предлагать вещества, невозможные для изготовления.

Мир на пороге революции

Способность искусственного интеллекта генерировать новые идеи дает пользователям информацию для определения лекарственных мишеней и предсказания поведения новых соединений. Он также используется для поиска новых применений старых лекарств, прогнозирования побочных эффектов новых препаратов и поиска способов отличить тех пациентов, которым лекарство может помочь, от тех, кому оно может навредить. Но, несмотря на этот прогресс, доктор Панде из компании Andreessen Horowitz, считает, что последние достижения знаменуют собой постепенные изменения.

Биомедицинские исследования, особенно в области биотехнологий и фармацевтики, неуклонно увеличивали свою зависимость от автоматизации и инжиниринга еще до того, как появились новые базовые модели. Теперь, когда это произошло, они, похоже, усиливают друг друга, – говорит он.

Искусственный интеллект в конечном итоге будет лечить заболевания, от которых еще нет лекарств, и поможет заменить лекарства с серьезными побочными эффектами. Изображение: assets-global.website-files.com

Новые базовые модели не просто позволяют работать с большими массивами данных – они требуют их использования, а высокоавтоматизированным лабораториям нужны массивы надежных данных. Словом, биологию теперь можно рассматривать как «систему обработки информации, хотя и чрезвычайно сложную». Некоторые и вовсе говорят о том, что ИИ

осваивают «язык биологии» и учится понимать, к чему привела эволюция, непосредственно на основе данных.

А вы знаете чем опасны поддельные лекарства и как их распознать? Ответ здесь!

Так, некоторые исследователи предсказывают появление моделей open foundation, которые будут интегрировать данные, охватывающие весь спектр – от последовательностей генома до историй болезни. Так или иначе, мир, кажется, стоит на пороге новой промышленной революции, которая изменит все. К счастью для всех этот процесс, скорее всего, будет постепенным и последнее слово должно оставаться за нами.